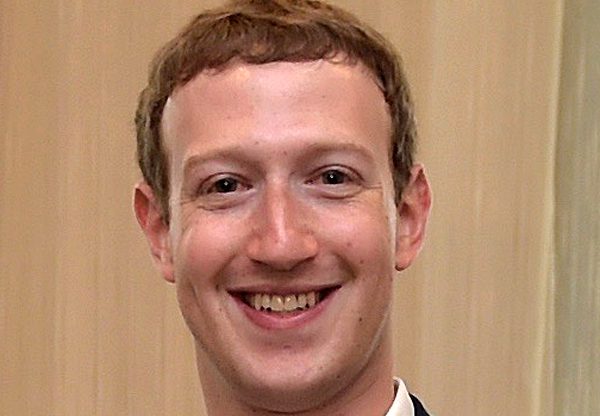

האם פייסבוק מגנה במיוחד על גברים לבנים?

ענקית הרשת החברתית מקפידה על מדיניות הסרת פוסטים מגה חסויה, אולם חשיפה חדשה מתוך ההנחיות כוללת את האמירה: "אנחנו מגנים על גברים לבנים" ● האמנם?

השבוע הגיעה פייסבוק (Facebook) לציון הדרך הלא ייאמן של שני מיליארד משתמשים חודשיים. לנוכח הנתון הזה עולה בהבלטה התהייה: איך מנהלים כזו מאסה של תקשורת בין אישית בהצלחה?

דו"ח חדש שהוציא פרופבליקה (ProPublica) – ארגון ניו-יורקי ללא מטרת רווח, שמגדיר את עצמו כמרכז לעיתונות עצמאית ומתמקד בתחקירים לתועלת הציבור – מפרט את התהליך המפותל, שלשמו מגייסת פייסבוק צוות שמונה לא פחות מ-7,500 מנהלי תוכן.

לפי פרופבליקה, הצוות הזה, שתפקידו לסקור את כלל התלונות והבקשות של משתמשי הרשת החברתית בנוגע לפוסטים ופרסומים שפורסמו בה, כולל אימונים לסיטואציות שונות. בין השאר תוארה בפרסום השאלה הבאה: "על אילו תת קבוצות אנחנו מגנים? נשים, ילדים, שחורים, או גברים לבנים?" לטענת התחקיר, התשובה – המפתיעה – של פייסבוק היא גברים לבנים, והיא מובאת במתכונת של איור ובו מופיעים חברי להקת הבקסטריט בויז בהירי העור.

למעשה, הדו"ח קובע שפייסבוק בנתה מערכת ניטור ושליטה על תגובות המגנה על "לבנים כמוני משנאה, אבל לא על ילדים שחורים".

אם הראיות שנתגלו על ידי פרופבליקה מדויקות, מדיניות החברה לגבי אופן הטיפול שלה בהפצת דברי שנאה עשויה להמחיש הבדלים בהתייחסותה לתכנים הספציפיים לקבוצות מסוימות של האוכלוסייה.

עשרות אלפי פוסטים נמחקים בכל שבוע

אלא שדיווחים קודמים הראו שפייסבוק מתייחסת למודרציה של הפרסומים שמופיעים בה קצת כמו אל בעיה הנדסית, ומחלקת לשם כך את הדברים לפי "מאפיינים מוגנים" כגון גזע ו-"מאפיינים לא מוגנים" כמו גיל. בנוסף, נמסר באותם דיווחים שיש לה נוסחה לקביעת האופן שבו סכימת הסיווג חלה על פוסט נתון.

ביום ג' האחרון סיפקה פייסבוק חשיפה של הסטטיסטיקה בכל הנוגע למחיקת דברי שנאה ברשת החברתית, כחלק מסדרה של פרסומים פומביים שנועדו להראות כיצד היא מטפלת בנושאים שנויים במחלוקת, כמו פייק ניוז.

במסגרת הפרסום סיפרה פייסבוק שהיא מוחקת מדי שבוע כ-66 אלף הודעות שהיא מגדירה כדברי שנאה. לפיכך, הנחישות שלה לייצר מאפיינים מוגנים ולא מוגנים אולי מובנת, ודי ברור שהיא כרוכה בבעיות פוליטיות ומוסריות.

מחיקת תוכן גורף נגד נשים, השארת תוכן ספציפי נגד נהגות

הקטגוריות המוגנות בפייסבוק, כפי שנודע בעבר וכפי שמתאר אותן ריצ'רד אלן, סגן נשיא פייסבוק למדיניות ציבורית באירופה, במזרח התיכון ובאפריקה, הן: מוגבלות חמורה או מחלה, וכן נושאים שקשורים במין, בגזע, במוצא אתני ולאומי, בשיוך דתי, בנטייה מינית ובזהות מגדרית. מנגד, הקטגוריות הבלתי מוגנות כוללות: מעמד חברתי, כיבוש, מוצא יבשתי, גיל או מראה חיצוני, וכן אידיאולוגיה פוליטית או דתית.

כך קורה שאם תוכן שלישי מכוון לכל המשתייכים לקטגוריה מוגנת, למשל לנשים, הוא ייחשב בעייתי וכנראה יימחק, בעוד שאם הוא מכוון לקבוצת משנה, זאת אומרת לקטגוריה לא מוגנת בתוך קטגוריה מוגנת, כמו נשים נהגות, הוא לא ייחשב כטעון פסילה.

מכך ניתן להבין, ושלא כפי שהציגה פרופבליקה את המצב, שהמדיניות של פייסבוק אפשרה למפקחים למחוק דברי שטנה נגד גברים לבנים, כי הם נכללו ב-"קטגוריה מוגנת", בעוד ששתי דוגמאות אחרות – ילדים שחורים ונהגים – שהוצגו בשקופית ובשאלה לבוחנים, נכללות בקטגוריה לא מוגנת. כתוצאה מכך, הערות ודיבור שנאה נגדם מותרים.

הבדל בין העברת ביקורת על יהדות להעברת ביקורת על יהודים

הלך חשיבה זה שופך אור גם על כך שהשייכות הדתית של האדם מוגנת, אבל הדת לא. למשל, קיים הבדל בין העברת ביקורת על יהדות להעברת ביקורת על אדם יהודי. אולם, ההבדל הדק בין השניים מוביל לתחומים אפורים רבים, שבהם נדרשים מנהלי התוכן לקבל החלטות אישיות.

סגן הנשיא אלן הסביר גם הוא כי לעתים קרובות אין "קונצנזוס ברור" על פוסטים מסוימים שבהם "המילים עצמן מעורפלות והכוונה מאחוריהן אינה ידועה, או שההקשר סביבן אינו ברור". במקרים אלה, תיאר, פייסבוק בודקת באופן פנימי את ההודעות המדוברות ומחליטה אם למחוק אותן או לא.

אלן הודה כי חלות לפעמים טעויות. לדבריו, אלה "מעוררות דאגה רבה במספר קהילות, כולל בקרב קבוצות שחשות שאנחנו פועלים – או לא מצליחים לפעול – מתוך הטיה".

מעניין להתייחס לדבריו של דייב וילנר, איש תוכן לשעבר בפייסבוק, שעזר בבניית ספר הכללים שלה, שאמר לפרופובליקה שהמערכת לניטור התכנים של החברה "שימושית יותר מכפי שאנחנו רגילים במערכת המשפט שלנו. היא ביסודה לא מכוונת לפי זכויות".

תגובות

(0)