אנבידיה: מצאנו שיטה חדשה ליצירת תוכן ויזואלי באמצעות AI

לפי החברה, כלי ה-AI החדשים שלה מאפשרים לתוכנות כפיקאסו ו-DALL-E לספק תוצאות אישיות לצרכי המשתמשים ● כך, במקום תמונה "רגילה" של "משה", אפשר להגדיר אובייקט חדש ולהציג אותו שותה אורנג'דה או בטיול משפחתי

אנבידיה חשפה אתמול (ד') כמה מחקרים חדשים, שיוצגו באוגוסט הקרוב בכנס SIGGRAPH 2023 שלה, שבהם, לטענתה, היא חושפת את הדור הבא של יצירת תוכן ויזואלי באמצעות בינה מלאכותית יוצרת תוכן. המחקרים הללו אמורים, לפי החברה, להראות את היכולת להגדיר תוכנות כמו פיקאסו של אנבידיה עצמה, DALL-E ועוד, כך שהן ילמדו לספק תוצאות שמוצעות באופן הרבה יותר אישי לצרכים של המשתמשים בהן.

"הנקודה שהתחלנו לעבוד עליה היא שהרבה פעמים, מה שאת.ה רוצה לייצר הוא דברים שרלבנטיים לך ולא משהו גנרי מהאינטרנט, למשל תמונות שמכילות את הכלב של מישהו, ולא איזשהו כלב. לדוגמה, עבור מנהל.ת מוצרים, תמונה שמשלבת מוצר מסוים עם דברים נוספים. בכלים הנוכחיים זה לא אפשרי, כי הם כלליים מדי", אמר פרופ' גל צ'צ'יק, מנהל קבוצת המחקר של הבינה המלאכותית באנבידיה ישראל, בשיחה עם עיתונאים.

לדבריו, השיטה החדשה שהחברה מציעה מהווה פריצת דרך, כי היא מאפשרת הגדרה ספציפית ביותר של אלמנט או אובייקט מסוים, ופותחת פתח למגוון רחב של שימושים עבור יוצרים, מעצבים, אנשי שיווק ומיתוג, בעולמות הגיימינג, המטאברס, הבידור, ואף בעולמות העסקי והמסחרי.

"מבחינה טכנית, הדרך שבה המודלים עובדים היא לקחת את המילים במילון ולהפוך אותן לווקטורים של מספרים, ואנחנו מייצרים עוד וקטור שמצטרף למודל. זה הרעיון, בגדול. מכיוון שמדובר בשבר חדש, אפשר לשלב אותו עם כל דבר במודל מבלי לפגוע בו", הוסיף פרופ' צ'צ'יק.

איך זה עובד בפועל?

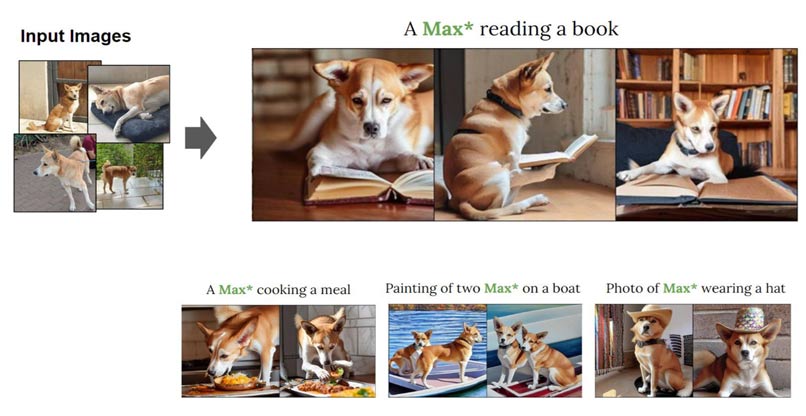

מה ההבדל בין דרישה ליצור תמונה בשיטה הרגילה לבין שיטה שבה מגדירים אובייקט מסוים? ניקח, לדוגמה, חבר בשם משה, שרוצים קצת לצחקק אתו עליו. בשיטה הנוכחית צריך להגדיר למודל שמשה הוא אדם, שהוא חבר, להוסיף תיאור של מה שרוצים שיהיה יחד אתו בתמונה ולקוות שיצא משהו דומה… אולי. אבל לפי אנבידיה, המשתמש יוכל לאמן את המודל מבלי לשנות דבר בדרך הפעולה שלו, עם אובייקט חדש שקוראים לו "משה". זה יכול להיעשות עם כמה תמונות של משה שקיימות במלאי, לדוגמה, ואז התיאור יכול להיות הרבה יותר פשוט, והתוצאה הרבה יותר מדויקת: משה שותה בקבוק אורנג'דה, משה בטיול עם המשפחה, וכיוצא בזה. התוצאה שהמודל יפיק תהיה הרבה יותר אפקטיבית בצורה הזו מסבירים באנבידיה.

כך זה עובד בפועל. צילום: אנבידיה

"אנחנו דוחפים את הטכנולוגיה הזו לגבהים חדשים – מאפשרים פרסונליזציה של טקסט לתמונה ובנוסף האצת הלמידה של קונספט חדש מדקות לשניות. הפיתוח עושה כמה דברים מאוד חשובים: מצליח להגיע לאיכות הרבה יותר טובה, תוך דמיון לתמונות שבהן משתמשים לצורך אימון המודל – אבל אחרת. יש טרייד אוף עם משהו שאפשר לשלוט בו אבל מהצד השני, הוא מספיק נאמן לתמונות שניתנו, והמודל הזה טוב יותר בשני הממדים. מה שחשוב לא פחות הוא שמדובר במודל קל משקל שמספק תמונות ברמה איכותית יותר ממה שידענו עד עכשיו", הסביר צ'צ'יק.

פיתוח ואבטחה

חלק מהטכנולוגיות שהציגה אנבידיה בוצעו בשיתוף עם חוקרים מאוניברסיטת תל אביב, ולפי צ'צ'יק הן אמורות להשתלב בעתיד במוצרים של החברה. "חשוב לנו מאוד שיתוף הפעולה האקדמי. מאוד חשוב לנו שהעבודות הללו יהיו שימושיות לקהילת המפתחים", אמר.

מה לגבי אבטחה ודיפ פייק? לא ברור בינתיים כיצד המודל ימנע שימוש לא חוקי בתמונות שלמשתמשים אין זכויות יוצרים עליהן, לדוגמה. רק באחרונה הציגה אנבידיה את NeMo Guardrails, כדי להילחם בסטייה של כלי יצירת תוכן מבוססי טקסט מהנושא, ולאפשר לכלי בינה מלאכותית יוצרת תוכן להתמקד במידע הקנייני של הארגונים עצמם. כמו כן, הוא כולל מסנני שפה. לפי צ'צ'יק, נכון לעכשיו לא מפותח כלי דומה לשימוש עם הטכנולוגיה החדשה שהציגה כעת החברה.

מהצד השני, לגבי היצירות עצמן הוא אמר: "קל לזהות את הדרך שבה הרבה מהתמונות הללו נוצרו – אולי לא לעין האנושית, אבל יש מודלים שמקלים על זיהוי בינה מלאכותית. בנוסף, יש טכנולוגיות שמאפשרות לשתול בתמונה סימן שמסמן שהיא נעשתה באמצעות בינה מלאכותית, כך שאני מאמין שתהיה אפשרות להימנע מדיפ פייק".

נשמע כמו Textual inversion או LORA. לא ברור למה הם חושבים שפרצו דרך איכשהו.